光纤让数据中心更加“绿色”

发布时间:2022-06-07 文章来源:深度系统下载 浏览:

|

网络技术是从1990年代中期发展起来的新技术,它把互联网上分散的资源融为有机整体,实现资源的全面共享和有机协作,使人们能够透明地使用资源的整体能力并按需获取信息。资源包括高性能计算机、存储资源、数据资源、信息资源、知识资源、专家资源、大型数据库、网络、传感器等。 当前的互联网只限于信息共享,网络则被认为是互联网发展的第三阶段。 07年8月,美国环境保护机构(EPA;epa.gov)公布了一个关于服务器和数据中心的能耗和效率问题的报告,引起了新一轮的讨论。从现有的状况来看,大部分的数据中心机房都部署了至少50%的铜缆布线系统。许多业内人士相信,向更加“绿色“的道路发展,整合性能和价格方面的优势,实现10G高速网络系统在数据中心的广泛应用将成为数据中心发展的必然之路。

采用图示的光纤上走线方式,可以免除地板下的布线,保证机房的制冷效果和降低能耗 根据EPA的报告,2006年,全美服务器和数据中心的能源消耗达到610亿千瓦时,约占全部美国用电量的1.5%左右,相当于美国物业消耗的平均水平 - 580万千瓦。也就是说,整个美国的数据中心电量的消耗,已经超过了其所有彩色电视机的用电总和。 这份报告同时强调了一个值得人们警惕的现象:2006年全美国服务器和数据中心的用电量是2000年的两倍多。如果按照这样的趋势发展,到2011年,这个数字将会再次翻两番,超过1000亿千瓦时,年消耗74亿美元。报告预计,目前全美国数据中心机房用电峰值达到7亿瓦,以此类推,2011年将会达到12亿瓦,这样算起来,需要增加10个电厂。

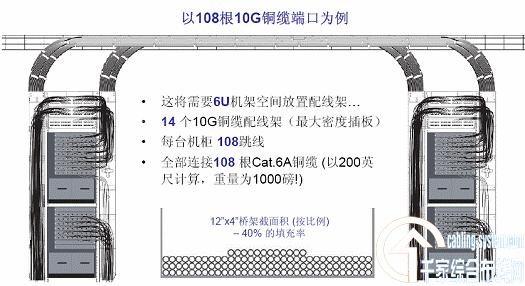

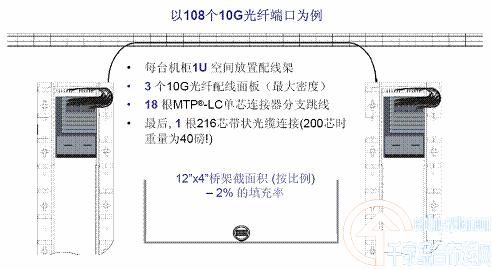

相同端口的铜缆与光缆所占用线槽的对比

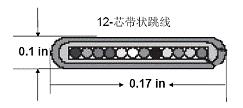

通过上图所示,可以非常清楚地得出结论:使用带状光缆替代铜缆可以在采购需求量上产生很大的差异,并且因而节约了大量空间和提高了设备间空气的流动性。 今天,数据中心所拥有的服务器和存储设备成百上千,同时,设备的需求量随着数据处理、存储和通信需求的不断上升还会进一步增加。但是,IT行业人员及其用户认识并了解推动这一趋势不断发展的真正的动力—就是刀片服务器的出现。因为这类设备在机房中占用极小的空间,具体的说,普通的42U的机柜可以安装21台传统的2U服务器,但是,如果使用刀片服务器,在同样的机柜中能够装载100到150台。 众所周知,刀片服务器非常好的实现了虚拟化的应用,这就让相关的IT管理人员减少了数据中心的服务器和其他设备的数量。我们可以参考一个非常普通的应用:假如一个企业的内部网络平台重需要运行14个系统,依据传统的解决方案,那么就需要相应的14台服务器来支持这些应用,同时还需要另外附加的服务器以实现冗余备份。但是,如果我们通过虚拟化的方式,你可以把多种业务的应用同时放在虚拟的服务器上,从而开放出你认为不同业务应用所需要的运算能力,通过这种虚拟化和使用刀片服务器,我们可以减少在数据中心机房内的服务器的数量。” 但是,刀片服务器也同样有自身的弱点。尽管刀片服务器外观看起来似乎是小型设备,但却有与其外观不一致的能耗,从而成为一个难题。因为当前的数据中心,特别是5年前建立的数据中心,其原有的设计是不能满足当前所面临的供电和制冷的需求,按照当时的规划,可能是每平方英尺30-50瓦(设备和制冷用电之和),如果现在使用刀片服务器并且保证其有效运行,那么就需要平方英尺100-150瓦。这就是为什么当前会有如此大量的数据中心和机房在重建,因为关注供电和制冷系统是一个必须要面对的课题” 供电和制冷的困境 那么光纤是如何减轻这些负担呢?大多数的数据中心都采用架空地板的方式设计:被架高的地板是一个充压通风的区域,在这里,冷空气从地板的风孔进入地板上方的设备区域,然后进入到网络柜中对设备进行设备降温。那么光纤作为基础设施部署于数据中心所带来的一个巨大好处就是可以移除几乎所有所有地板下的传输介质。 非常普遍的现象就是由于铜缆相当沉重,因此几乎都被放置于地板下面,这实际上造成了气流的障碍,限制了地板下空气的流动。 而事实上,要实现相同的性能却只需少量的光纤就可以完全取代那些数据中心的IT经理们需要在路径、空间、机架以及垂直理线器中布放数量惊人的铜缆。举例来说,一个能够在10G网络上传输108个通路的216芯光缆,直径仅0.7英寸,而铜缆要达到相同性能就需要几乎两倍直径,谈到这些线缆的重量,如果采用六类增强型铜缆,按照200英尺的长度计算,其重量将近1000磅;而同样长度的216芯光缆,重量仅40磅。 从另一角度来看,我们可以对比关于12芯带状光缆和六类铜缆,显然,带状光缆要比铜缆线径小得多。从而体现出线架/槽道中的线缆数量的差异性,换句话说,同样功能和达到其需求性能的光缆在桥架内的填充率不足2%,远小于铜缆的40%。因此选择光纤,就意味着避免阻塞空气流通并节省有限的空间。

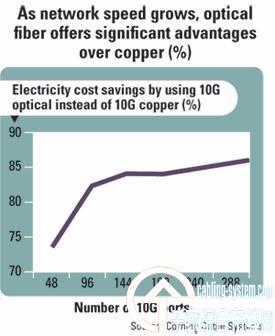

小型化和轻便的光缆可以更好地利用上走线的桥架布线方式,这种方式相对地板下走线,提高了有效的被动式散热。 现在,我们再来面对另外一个非常重要的话题-制冷。根据EPA报告称,在数据中心中支持IT设备的供电和制冷基础设施占整个数据中心能源消耗的50%。同时IDC的分析师预测,到2010年在一个新的服务器开销中,有71%的费用要用于供电和制冷。 随着数据中心越来越多的使用刀片服务器,将导致更多的电力消耗,更多的热量产生,其制冷的需求也随之进一步增加,但是,光纤可以减轻来自这些方面这些压力。引用一张EPA的图表,可以看出,每提供1千瓦的电力给网络设备,就要提供1千瓦的电力来供应制冷系统。康宁光缆系统对经过详细的试验和计算出了光纤和铜缆两种介质在传输10G时的能源消耗数值(见下图)。是以288个网络端口的10G为例,与铜缆相比,可以看到光纤网络设备所需能源及用于其制冷的能耗,节省了近86%的成本,这一数字是非常让人震惊的。

采用了源自EPA的报告,康宁光缆系统得出这样的结论: 10G铜系统要比10G光系统的能耗和制冷成本多出86%。 10Gbps速率应用的导火索 IEEE 802.3an已经定义了铜缆传输10G的标准,同时也已经有很多的产品可以提供用户选择。今天,多数10G网络都应用在金融机构或者较大型的数据中心,但是随着越来越多的IT经理认识到光纤的经济效益和绿色效应,这种状况将会发生很大变化。从某种意义上说,光系统在目前的网络层应用处于不利的位置,主要是价格因素,但是随着10G甚至更高速的网络的应用普及,光纤网络的性价比将会得到充分的体现。 我们可以基于有源器件作一些简单的探讨,对于10GBase-T器件,SFP+收发器在10GBase-SR的应用将逐渐地降低其能耗和成本。SFP-MSA协议规定最大的功耗是1瓦,但目前实际采用的大约只有0.5瓦。相对而言,10GBase-T应用在物理层则需要10-15瓦的功率才能驱动器件,而且也只是100m内的传输距离。而SFP+的传输距离则可以达到300m.。 此外,SFP+可支持48个端口的插板,每端口耗电0.5瓦,48口就需要24瓦。通常的插板需要大约60瓦,因此我们必须在60瓦功耗的预算内进行。在10GBase-T应用中,每口耗电10-15瓦,驱动铜缆插板,按照每口10瓦计算,可支持6个端口。这样,要想获得与光纤同样的应用带宽,就必须增加数倍的10G铜缆插板,因此这些更多的额外的功率不仅用在每个端口的能耗上,而且还要驱动另外插板运行上。” 在进行有源器件对比时,不应仅仅停留在交换层面,还应包括接口层面。服务器接口或者适配卡依靠服务器上本身的PCI总线供电。一般而言,PCI总线提供的电能约25瓦。如果需要的电能超过25瓦则需要外部供电。目前市场上的以太网适配卡耗电在25瓦以下,可支持30m的传输距离。更长的传输距离需要更多的电能,相应地,也需要额外的供电。但是对于应用于10G网络的光网络接口卡来说,其能耗不会超过9瓦甚至更低,这对服务器以及所消耗的巨大电能来说,其意义就非同小可了。任何降低服务器及各项应用的能耗的举措,都是求之不得的。 总而言之,在数据中心部署光纤网络而不是铜缆系统将会大幅减少能源消耗、提高制冷效果、改善整体机架和架空地板的空间利用率。尤其在10G这样的传输速率应用中,光纤将比铜缆系统更具显著的经济性。 在不久的将来,随着更多的企业将数据中心向10G甚至更高速的网络移植,光纤将会发挥更大的作用。目前,IEEE正在着力于40G和100G这样的下一代高速网络标准的制定:服务器支持40G,网络核心层支持100G,这些应用都将依靠光纤系统(单模和多模)来实现。这些带给我们更深的思考就是:10G网络对于今天的我们是够用的,如果在今后达到40G和100G时,我们的基础设施该怎样呢? TIA 942标准让你置身困境之外 能够帮助企业降低能耗的有效途径就是遵循TIA942 标准中关于数据中心通信基础设施中有关冷热通道的定义进行规划。虽然TIA942 标准在2005年就已经颁布了,但事实上大多数数据中心的建设并没有将这些规范付诸于自己的规划和建设之内.

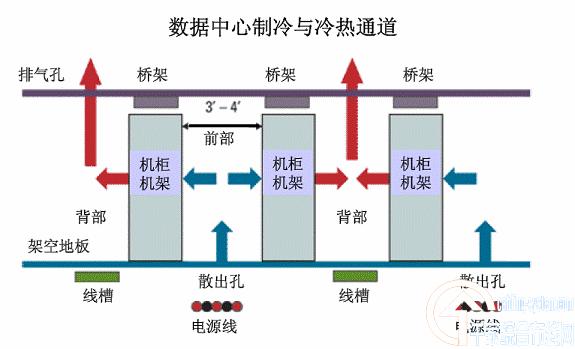

TIA942标准中对于冷热通道的设计是有助于对相对集中的设备进行散热和促进整个数据中心的气流循环。 下面我们可以看到这些工作的原理:将服务器和其他设备机架“面对面、背对背”式隔离交错排列,形成间隔的冷通道和热通道。 这样,在设备面对面的通道中,冷空气从网络设备前面的架空地板的散出孔出来后,经过机柜和设备的内部运行后变成热空气,再从机柜背面排出;在背对背的通道中,热空气上升,从天发板的排气口溢出。散热就是这么简单! 简而言之,遵从TIA 942标准将会避免一些麻烦。因此,当你需要建立一个新的数据中心时,冷热通道的设计也是需要认真考虑的关键问题之一。 网络的神奇作用吸引着越来越多的用户加入其中,正因如此,网络的承受能力也面临着越来越严峻的考验―从硬件上、软件上、所用标准上......,各项技术都需要适时应势,对应发展,这正是网络迅速走向进步的催化剂。 |